Neko Yuki

Neko Yuki 17/07/2025 19:36:24

Chatbot của Dược sĩ Tiến: Hơn ChatGPT thật không?

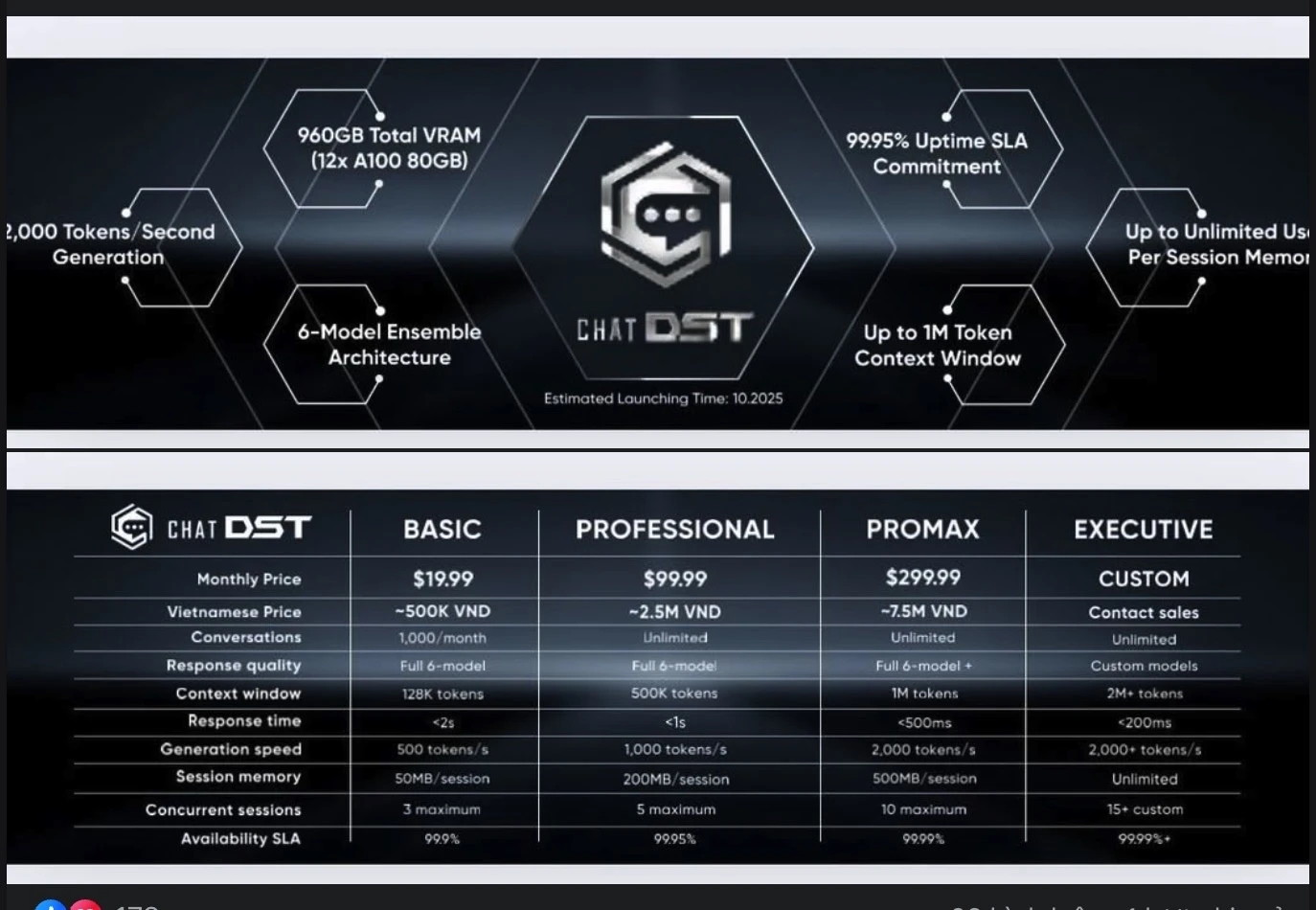

Ngày 14/7, ông Phạm Minh Hữu Tiến – được biết đến với biệt danh Dược sĩ Tiến – đã giới thiệu chatbot AI mới mang tên ChatDST tại một sự kiện truyền thông. Trong phần trình bày, ông Tiến tuyên bố ChatDST sở hữu thông số kỹ thuật vượt trội hơn cả ChatGPT, chatbot AI nổi tiếng của OpenAI.

Theo mô tả, ChatDST được xây dựng với dung lượng bộ nhớ VRAM lên đến 960 GB, gấp đôi so với mức 480 GB mà ông Tiến cho là của ChatGPT. Nền tảng còn được giới thiệu có khả năng xử lý 2.000 token mỗi giây, hoạt động ổn định 99,95% thời gian, và đặc biệt là có thể ghi nhớ không giới hạn trong mỗi phiên làm việc. Ngoài ra, chatbot này còn được “nhúng” tính cách cá nhân của ông Tiến và tích hợp dữ liệu chuyên ngành mỹ phẩm.

Một số chi tiết khác bao gồm kiến trúc kết hợp 6 mô hình AI, khả năng hiểu ngữ cảnh lên tới 1 triệu token, và được phát triển dựa trên nền tảng Llama 403 tỷ “neuron”. Dự án được công bố sẽ phát hành vào tháng 10 tới, với giá sử dụng dao động từ 20 đến 300 USD.

Tuy nhiên, ngay sau khi video sự kiện được lan truyền, cộng đồng công nghệ và chuyên gia AI đã nhanh chóng bày tỏ hoài nghi về các thông số này.

Theo ông N.B – một kỹ sư AI làm việc trong lĩnh vực mô hình ngôn ngữ lớn – phần lớn thông tin được đưa ra là không nhất quán về mặt kỹ thuật.

Thứ nhất, khái niệm “neuron” không được dùng trong mô tả mô hình AI hiện nay. Các mô hình như Llama được đo bằng tham số (parameter), không phải neuron. Ngoài ra, phiên bản Llama hiện chỉ có 405 tỷ tham số do Meta công bố mã nguồn, không tồn tại bản “403B” như ông Tiến đề cập.

Thứ hai, thông tin ChatGPT vận hành trên 480 GB bộ nhớ VRAM chưa từng được xác nhận bởi OpenAI. Trong khi đó, cấu hình của ChatDST được công bố là chạy trên 12 GPU Nvidia A100 80 GB – tương đương 960 GB tổng VRAM, trị giá ước tính khoảng 8,4 tỷ đồng.

Con số này nếu so sánh với hệ thống mà OpenAI đang vận hành – với khoảng 290.000 GPU – là vô cùng nhỏ bé. OpenAI tiêu tốn trung bình 100.000 USD/ngày chỉ để duy trì mô hình GPT, vượt xa quy mô máy chủ nhỏ mà ông Tiến đề cập.

Một trong những điểm khiến giới công nghệ nghi ngờ nhất là tốc độ xử lý 2.000 token/s – con số cao gấp hàng chục lần so với tốc độ thực tế hiện nay của các mô hình hàng đầu. ChatGPT hiện chỉ đạt khoảng 50–100 token/s, còn Claude dao động từ 40–80 token/s tùy điều kiện hệ thống.

Theo nền tảng HuggingFace, mô hình Llama 405B cần ít nhất 810 GB VRAM chỉ để tải mô hình. Với cấu hình 960 GB, máy chủ của ChatDST chỉ còn dư khoảng 150 GB để xử lý tác vụ, đủ phục vụ từ 1 đến 3 người dùng đồng thời. Dù có giảm chất lượng mô hình để tiết kiệm tài nguyên, khả năng phục vụ cũng không quá 9 người dùng cùng lúc.

Ngoài ra, ông Tiến chưa công bố bản demo, mã nguồn, tài liệu kỹ thuật hay minh chứng vận hành. Video sự kiện công bố hiện cũng đã bị gỡ khỏi nền tảng YouTube, làm dấy lên nghi ngờ về tính xác thực của dự án.

Hiện tại, ChatDST vẫn là một dự án nằm trên lý thuyết, chưa có sản phẩm thực tế để kiểm chứng. Trong khi đó, việc so sánh trực tiếp với ChatGPT – sản phẩm trị giá hàng tỷ USD – là điều cần hết sức thận trọng. Nếu không có cơ sở kỹ thuật và đội ngũ phát triển phù hợp, việc tuyên bố “hơn ChatGPT” có thể phản tác dụng, làm giảm uy tín của người công bố thay vì tạo ấn tượng.