18/06/2025 05:48:14

Google ra mắt Gemini 2.5 Flash-Lite: mô hình AI siêu rẻ, có chế độ ‘tư duy’

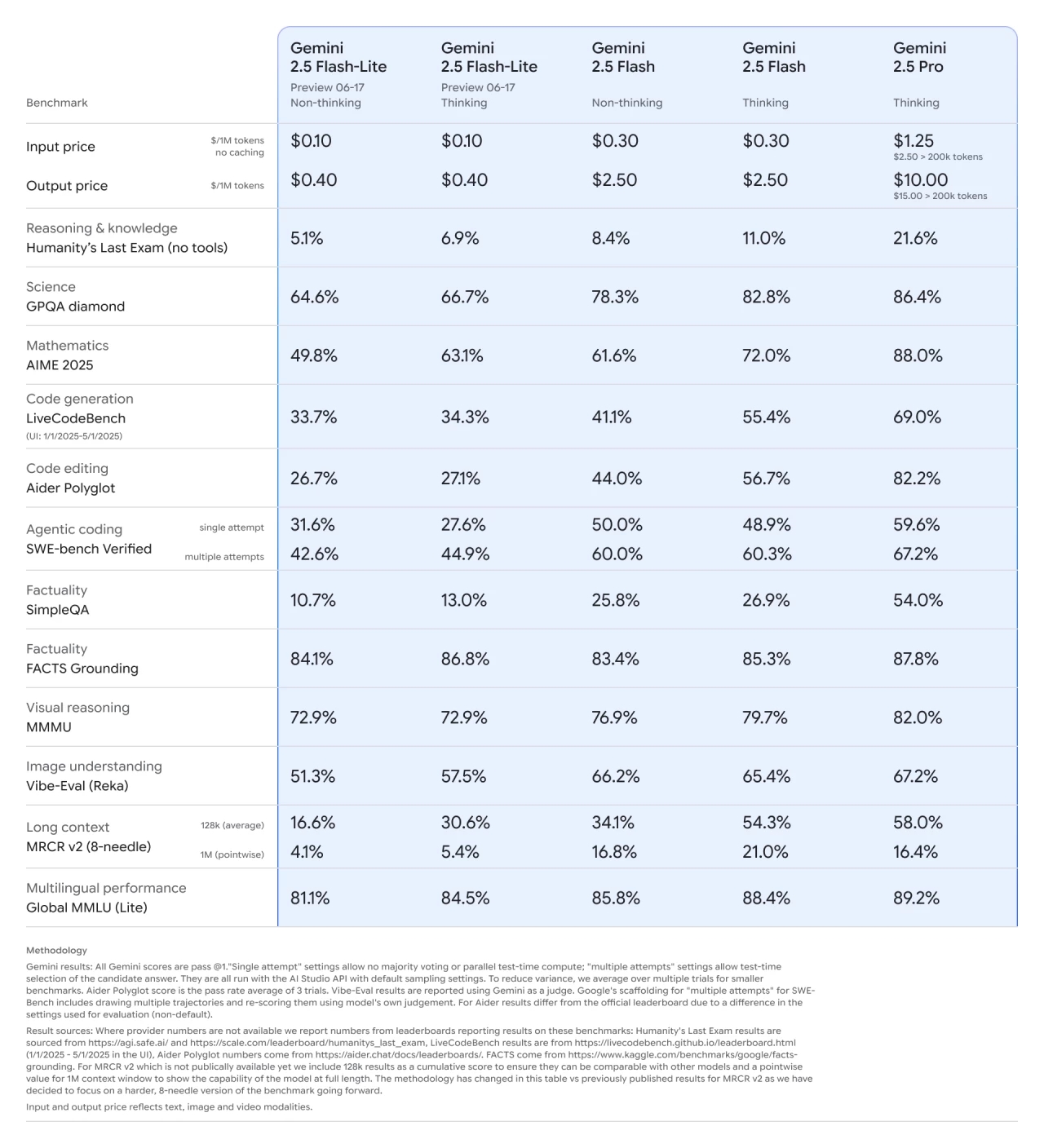

Ngày 17/6, Google chính thức công bố mô hình AI Gemini 2.5 Flash-Lite, một lựa chọn mới trong gia đình Gemini 2.5, bên cạnh các phiên bản mạnh mẽ hơn là Gemini 2.5 Pro và Gemini 2.5 Flash.

Flash-Lite được thiết kế để xử lý những tác vụ đơn giản nhưng cần tốc độ cực nhanh và quy mô lớn như dịch thuật, phân loại dữ liệu, hoặc truy xuất thông tin cơ bản. Mô hình này không được tối ưu cho những câu hỏi phức tạp, khi điểm số chỉ đạt 5,1% trong bài kiểm tra tư duy khó "Humanity’s Last Exam".

Tuy nhiên, Flash-Lite lại có một tính năng gây tò mò: “Thinking mode” – chế độ cho phép mô hình xử lý chậm hơn để cải thiện chất lượng phản hồi. Khi bật chế độ này, hiệu suất của mô hình tăng đáng kể. Chẳng hạn, với bài kiểm tra toán học khó AIME 2025, kết quả tăng từ 49,8% lên 63,1%. Tương tự, khả năng tìm kiếm thông tin trong tài liệu dài cũng tăng gấp đôi về độ chính xác khi Thinking mode được kích hoạt.

Về chi phí, Flash-Lite có mức giá rẻ nhất trong các mô hình Gemini hiện tại: chỉ 0,10 USD cho mỗi 1 triệu token đầu vào và 0,40 USD cho mỗi 1 triệu token đầu ra – phù hợp cho các nhà phát triển cần xử lý dữ liệu ở quy mô lớn với chi phí thấp.

Truy cập và thử nghiệm

Mô hình hiện đang ở giai đoạn dùng thử (preview) và có thể truy cập ngay qua hai nền tảng chính:

- Google AI Studio

- Vertex AI (dành cho nhà phát triển)

Trong khi đó, các mô hình Gemini 2.5 Flash và Pro – mạnh hơn và ổn định hơn – đã được tích hợp vào ứng dụng Gemini chính dành cho người dùng phổ thông, đồng thời cũng hiện diện trong hệ sinh thái dành cho lập trình viên.

Google tiết lộ rằng những phiên bản tùy chỉnh của Flash-Lite và Flash hiện đã được tích hợp vào chính công cụ Tìm kiếm (Search), góp phần hỗ trợ xử lý các truy vấn AI nhanh hơn.